slurm 作业管理

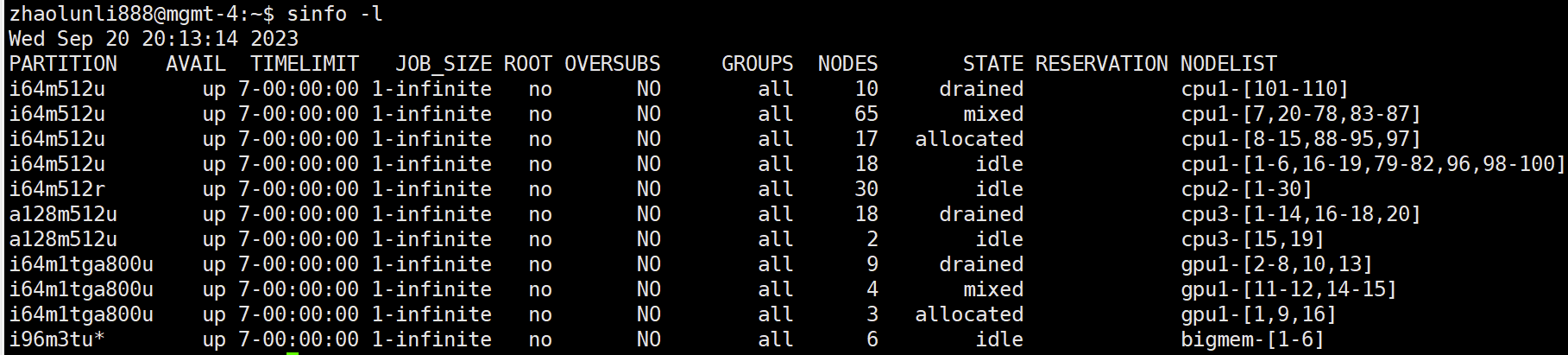

显示队列、节点信息:sinfo

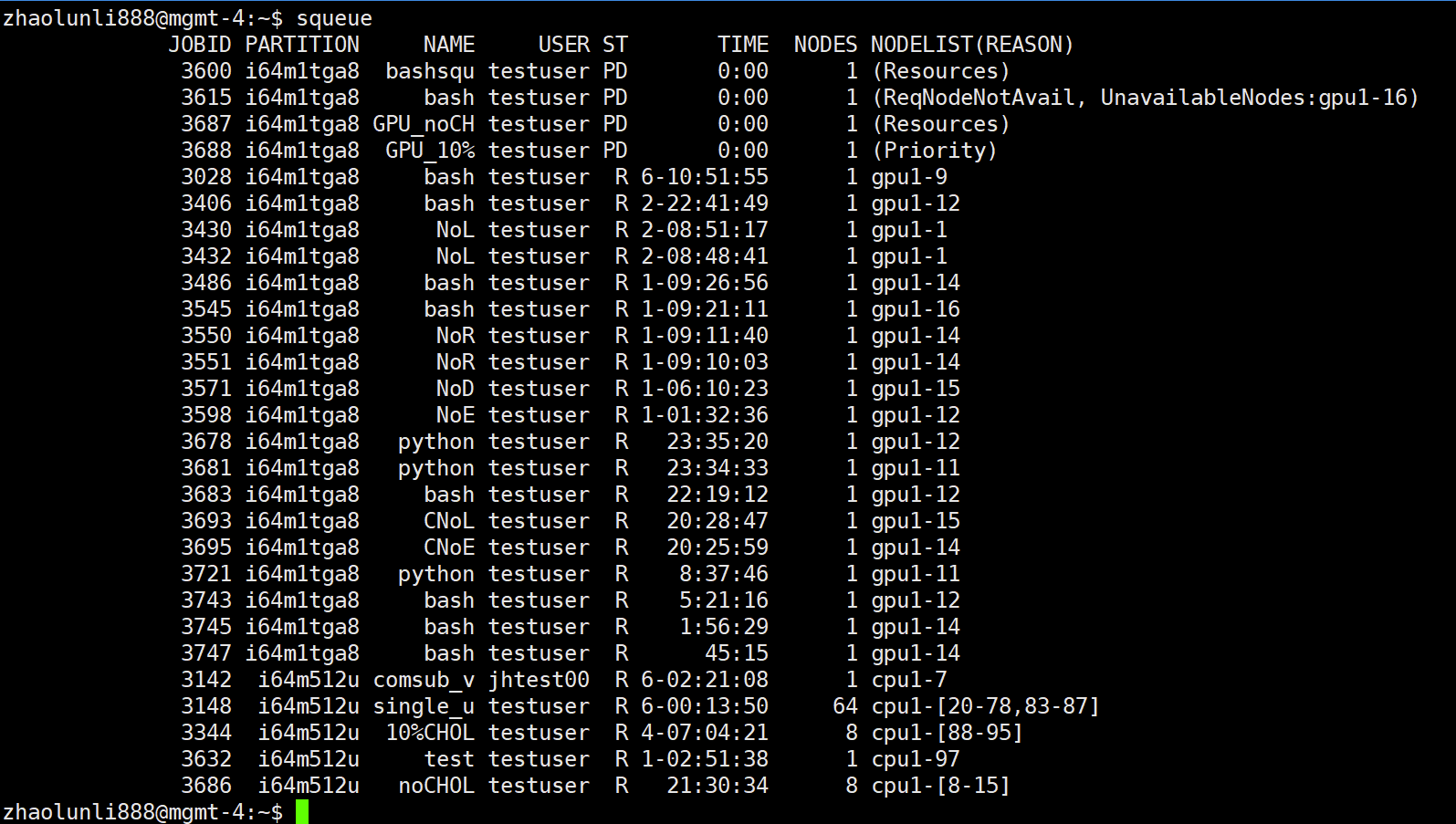

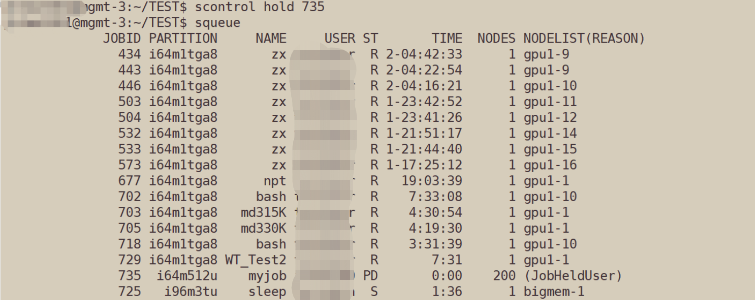

查看队列中的作业信息:squeue

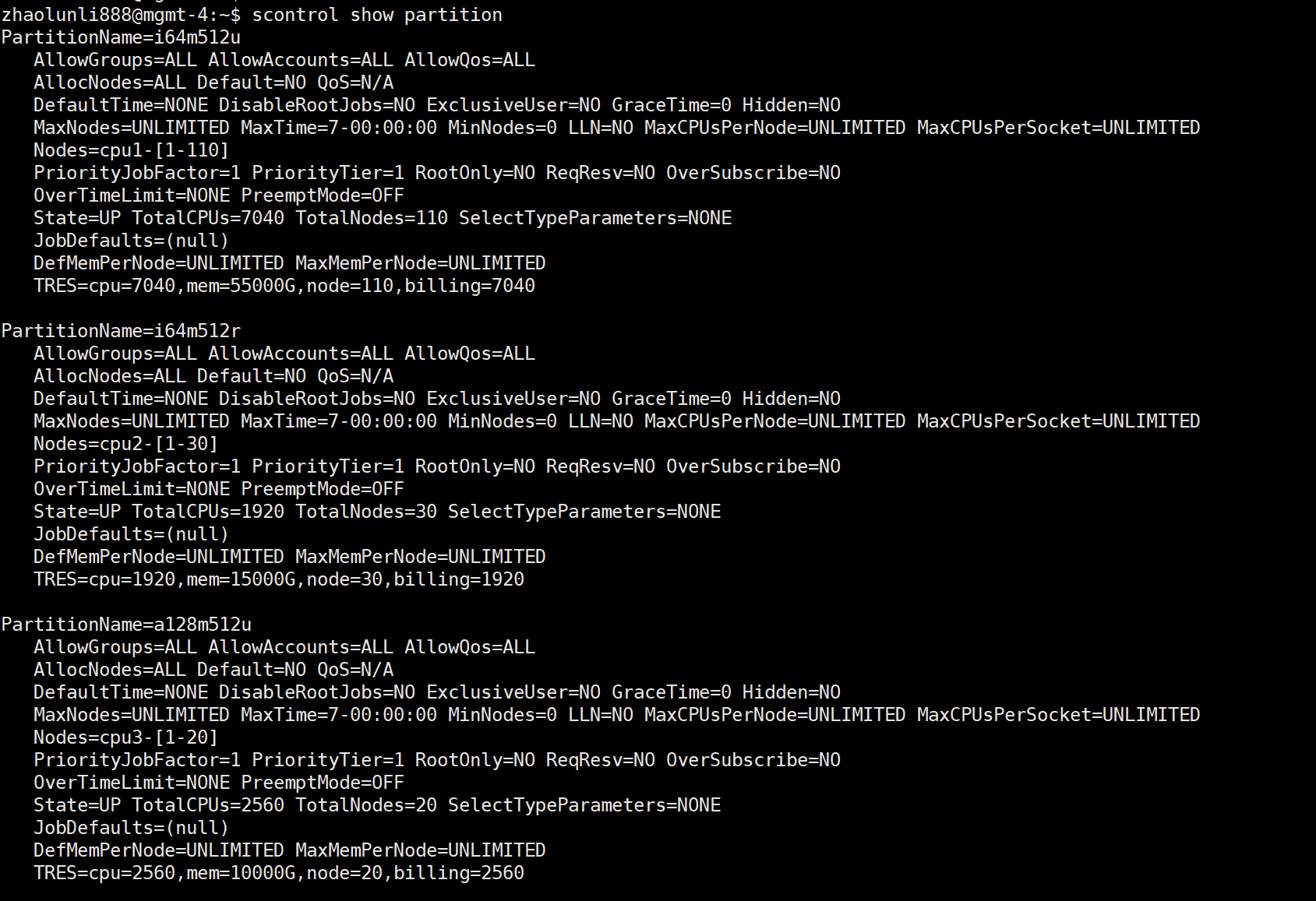

查看详细分区(队列)信息:scontrol show partition

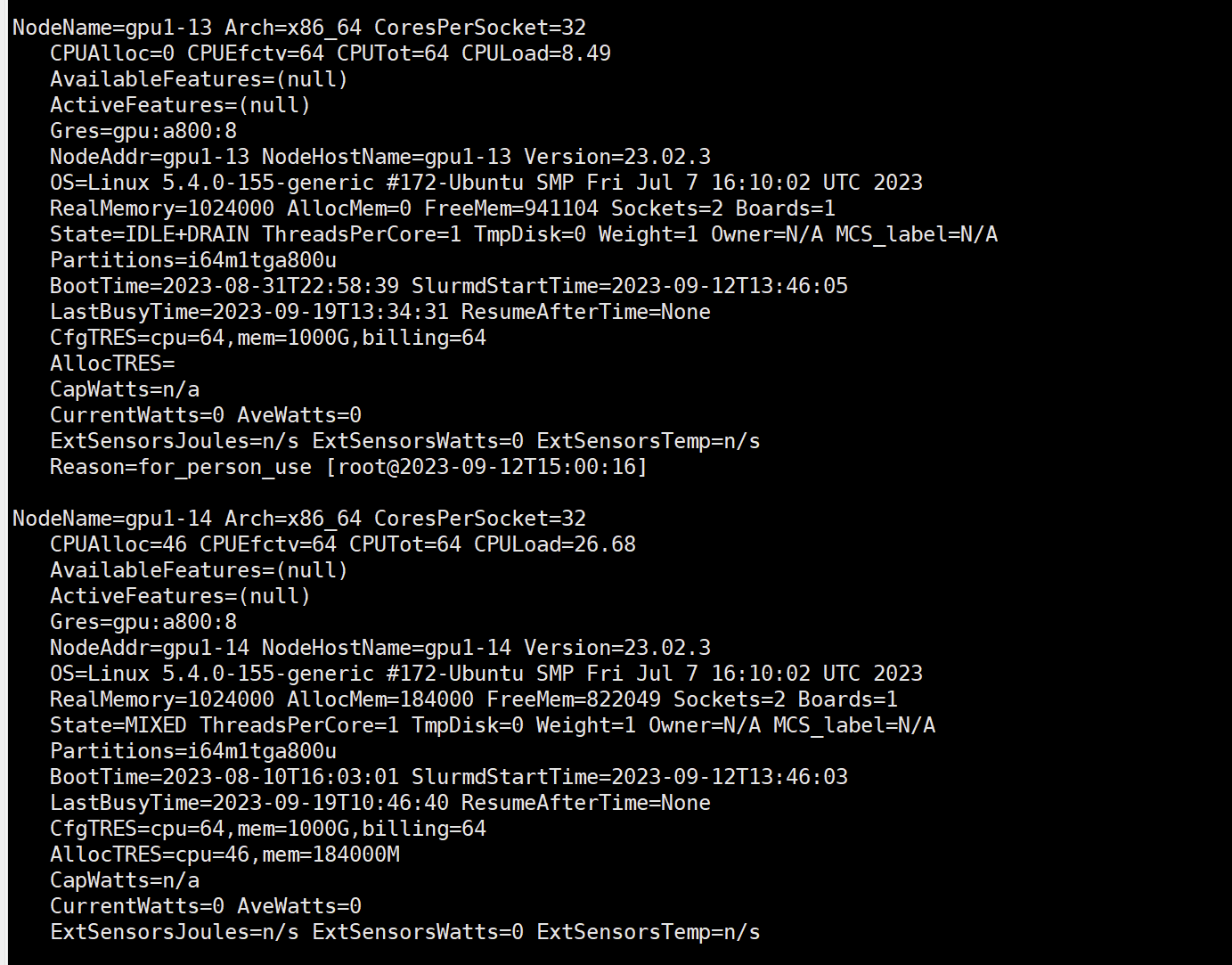

查看详细节点信息:scontrol show node

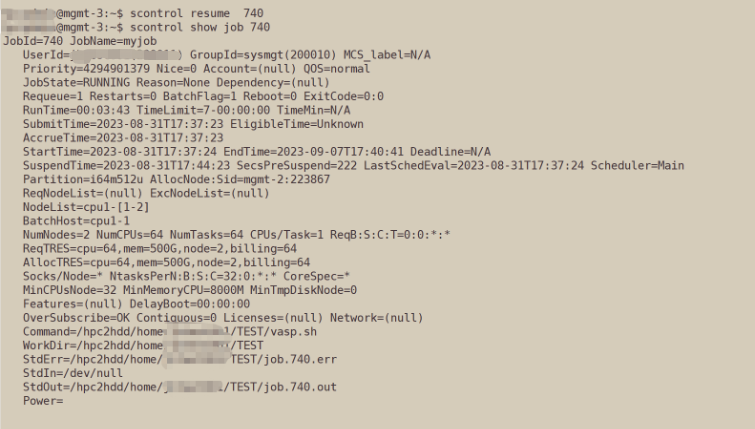

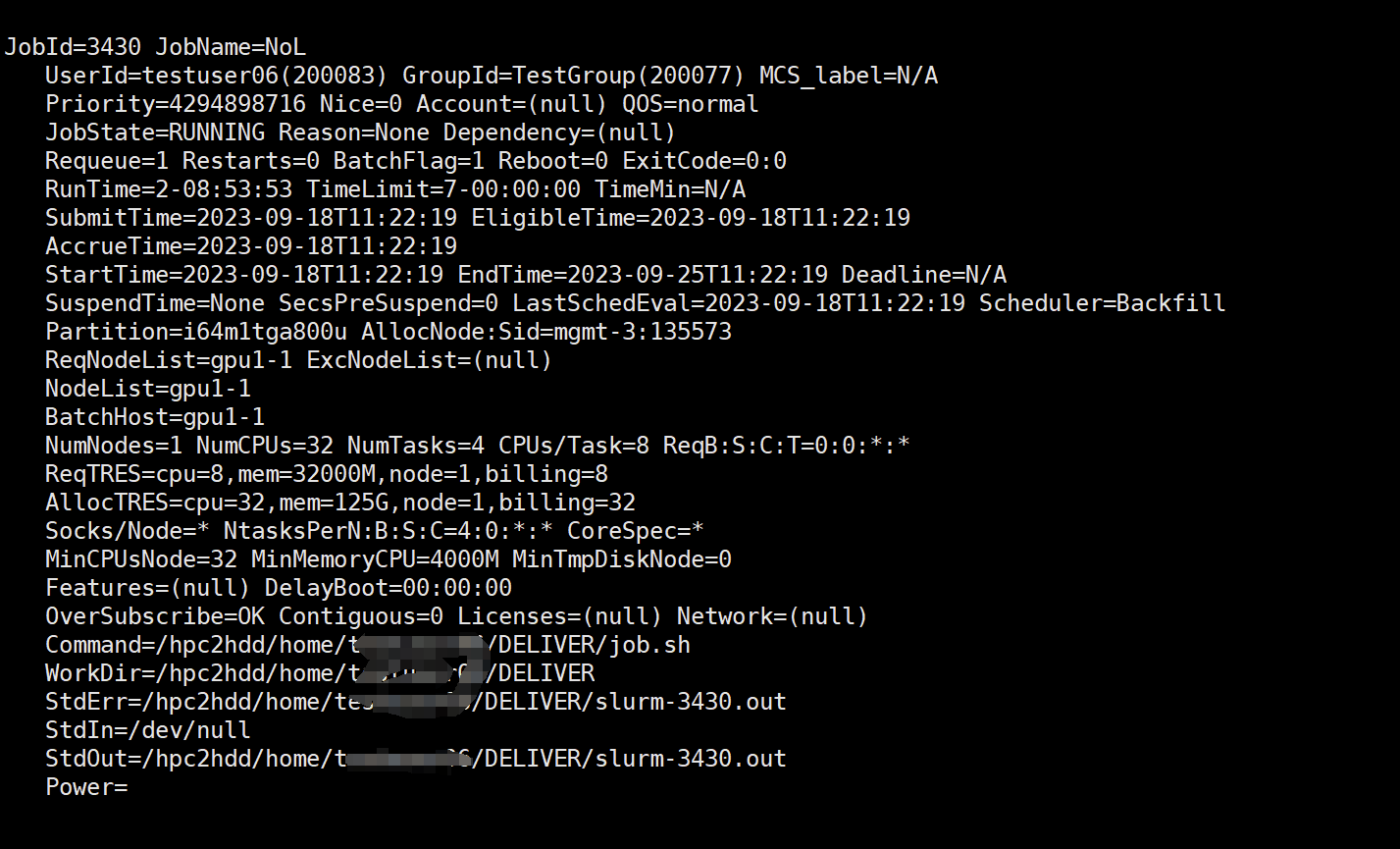

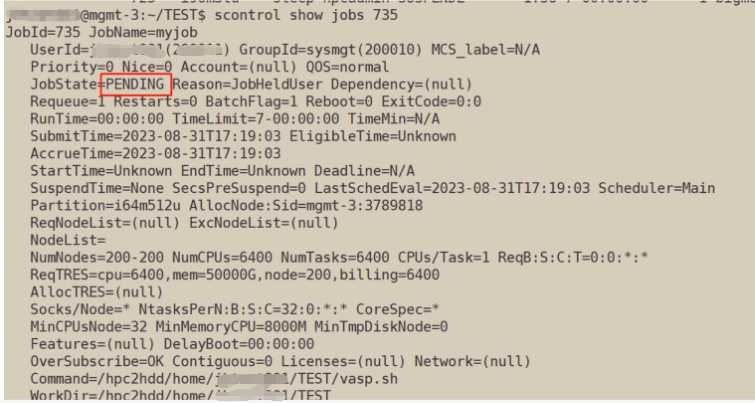

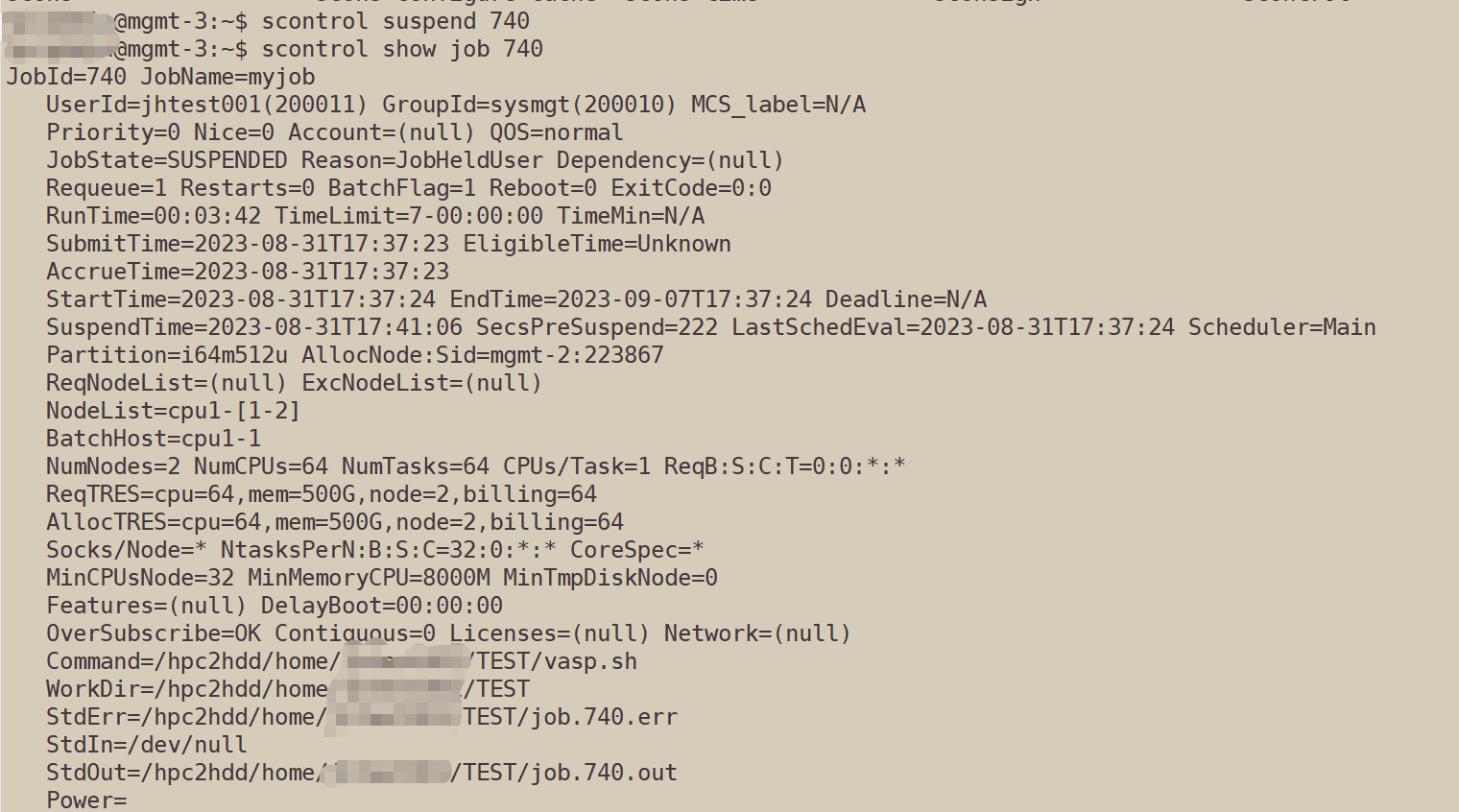

查看详细作业信息:scontrol show job $JOBID

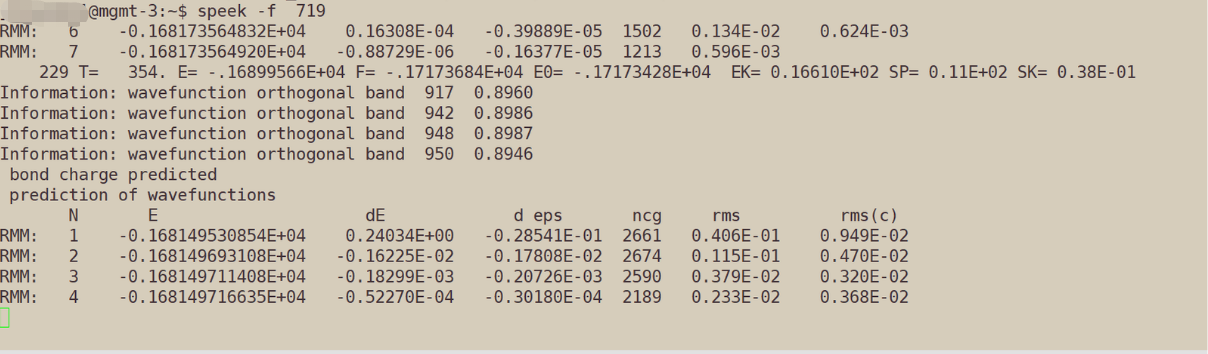

查看作业动态输出:speek

注意:该命令不是slurm自带命令,是封装后的

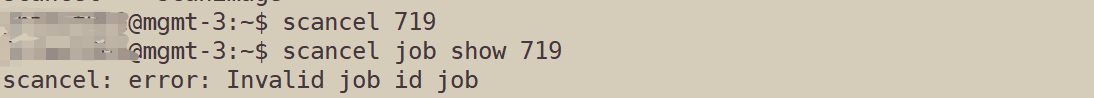

终止作业:scancel job_id

挂起排队的作业: scontrol hold job_id

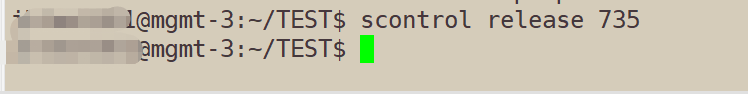

继续排队中挂起作业:scontrol release _job_id

挂起运行的作业:scontrol suspend job_id

恢复挂起运行中的作业:scontrol resume job_id