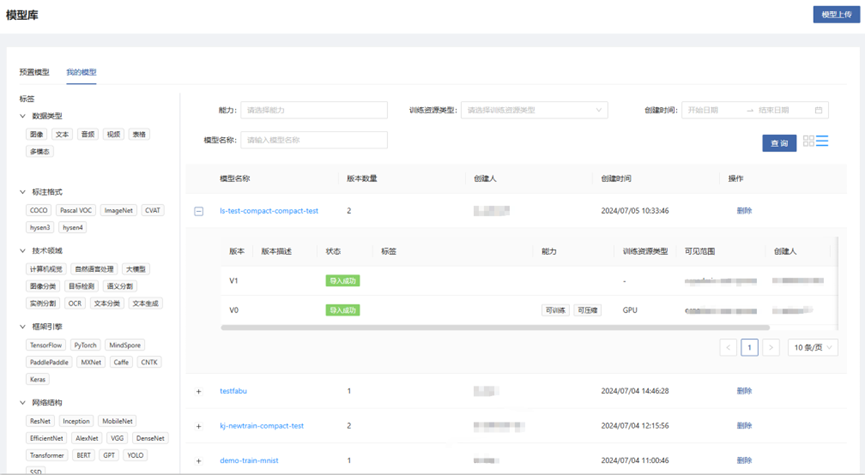

模型库

模型库是模型管理中心,可导入所有开发或训练任务生成的模型并进行统一管理,也支持本地模型上传。提供版本控制等功能,并且预置了丰富的模型,以满足不同应用场景的使用。

路径:人工智能 --- 代码开发与训练 --- 模型管理

模型上传

支持用户将本地开发的模型上传到模型库进行统一管理。

- 若上传的是用户自定义模型包(内容可以是任意文件),则上传后模型包中的文件存储于模型的算法目录。

- 若上传的是模型库中点击“下载全部”按钮得到的模型包(含有 code、model 文件夹和 manifest 文件),则上传后 code、model 文件夹的内容分别存储于模型的算法目录、模型目录。

模型详情

训练配置

- 打开配置训练开关后,模型能力支持“可训练”,才能使用此模型版本进行模型训练。

- 页面中显示了进行模型训练时使用的配置信息,包括启动环境配置、接收平台参数、超参、推荐资源配置、可视化、分布式训练。

启动环境配置

- 镜像:启动任务时使用的镜像。

- CPU 架构:镜像和资源使用的 CPU 架构。

- 使用 conda 环境:是否使用 conda 环境进行训练。需要注意的是,若使用了 conda 环境,请勿随意删改此环境,否则可能造成任务运行失败。

- 启动入口:镜像内的启动入口。若启动脚本为 py 文件,启动入口可以写为 python;若启动脚本为 sh 文件,启动入口可以写为 bash。

- 启动脚本:从模型版本的算法目录中选择启动脚本文件,仅支持 .py 或 .sh 格式。

- 启动命令预览:可以预览完整的启动命令。

接收平台参数

启动模型训练任务时,平台会动态生成这些参数内容,并以命令行参数的形式传递给启动脚本。此处需要填写启动脚本中对应的命令行参数名称。

- 数据集路径:模型训练数据集的挂载路径。

- 增量训练权重路径:增量训练权重文件的挂载路径。

- 任务输出路径:模型训练任务的输出路径。平台会分配唯一的持久化输出路径,请在代码中将需要保存的数据存储到此路径。

超参

模型训练的超参,以命令行参数的形式传递给启动脚本。

推荐资源配置

- 资源类型:模型训练时使用的资源类型。

- CPU、GPU、NPU:模型训练推荐使用的资源规格。

训练可视化

选择支持的可视化类型,请在代码中将可视化输出存储到接收平台参数的“任务输出路径”中,平台会自动读取。

分布式训练

若代码支持分布式训练,则可选择支持。

评估配置

- 打开配置评估开关后,模型能力支持“可评估”,才能使用此模型版本进行模型评估。

- 页面中显示了进行模型评估时使用的配置信息,包括启动环境配置、接收平台参数、超参、推荐资源配置。

接收平台参数:

- 数据集路径:模型评估数据集的挂载路径。

- 模型权重路径:模型训练生成的权重文件的挂载路径。

- 任务输出路径:模型评估任务的输出路径。平台会分配唯一的持久化的输出路径,请在代码中将需要保存的数据存储到此路径。

推理配置

- 打开配置推理开关后,模型能力支持“可推理”,才能使用此模型版本进行模型推理。

- 页面中显示了进行模型推理时使用的配置信息,包括启动环境配置、接收平台参数、推理参数、推荐资源配置。

接收平台参数:

- 模型权重路径:模型包模型目录的挂载路径

推理服务监听端口

推理服务框架监听HTTP推理请求的端口

推理服务访问端点

推理服务框架处理HTTP推理请求的访问端点

推理数据类型

选择输入到推理模型的数据类型。平台使用不同的方式来可视化推理原始数据及推理结果: