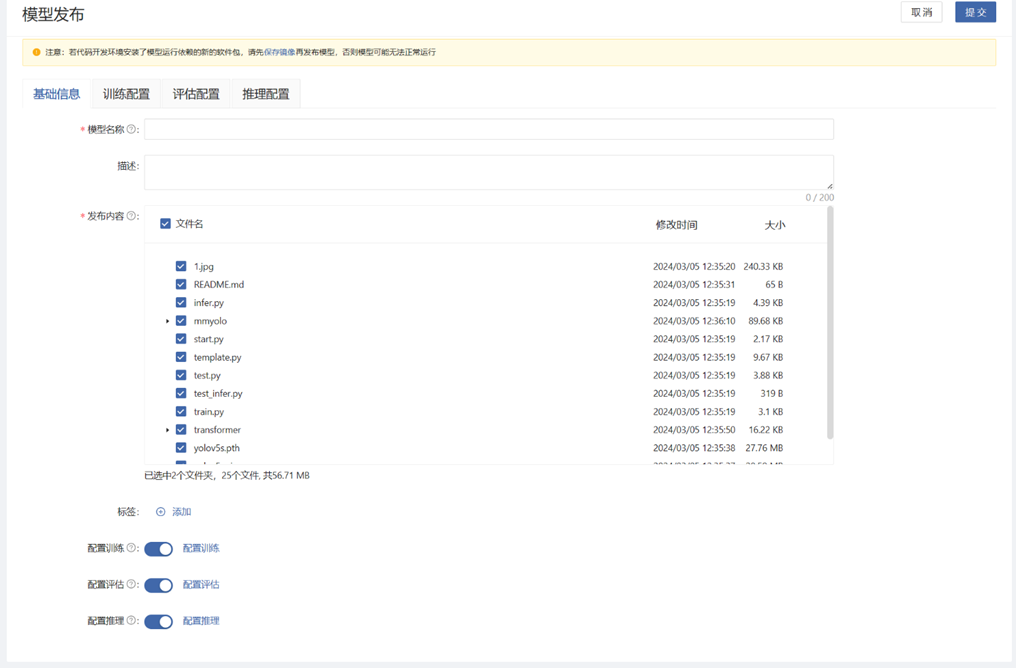

模型发布

模型算法代码开发完成后,可以将模型发布到模型库。这便于固化版本管理、再次训练评估以及分享给其他用户使用。

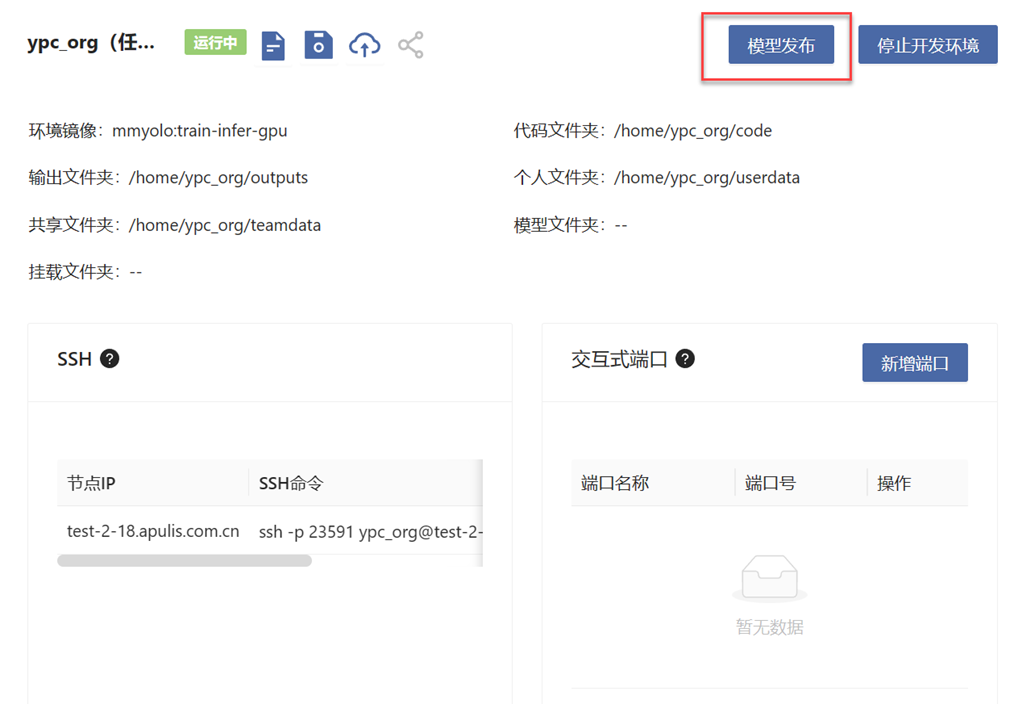

在开发环境中,点击“模型发布”按钮,进行发布。在模型发布页面中,可以配置模型的基础信息、训练配置、评估配置和推理配置。

提示

若代码开发环境安装了模型运行依赖的新软件包,请先保存镜像再发布模型,否则模型可能无法正常运行。

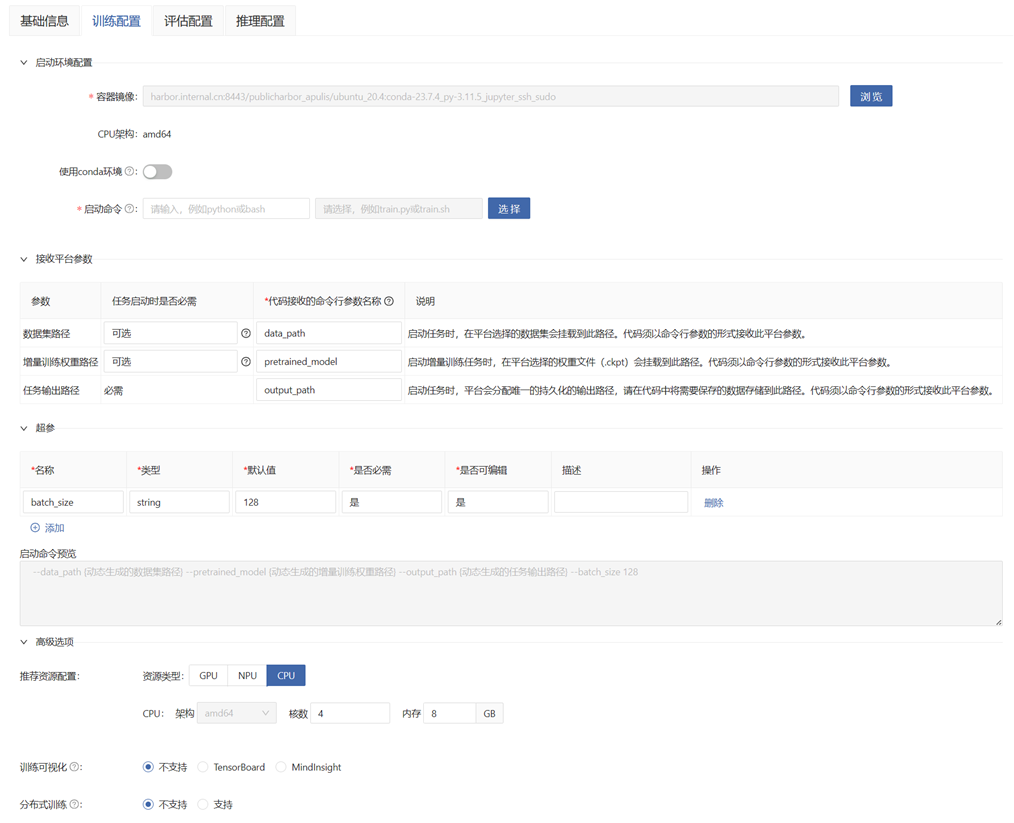

训练配置

若发布后需要进行模型训练,则需配置。也可发布后在模型库配置。使用此模型进行模型训练时,会按照下列配置信息启动任务:

- 容器镜像:启动任务时使用的镜像,默认填写开发环境使用的镜像。

- CPU 架构:镜像和资源使用的 CPU 架构,自动填写。

- 使用 conda 环境:是否使用 conda 环境进行训练。若代码开发使用了 conda 环境且没有保存镜像,则开启。需要注意的是,模型发布后,请勿随意删改此 conda 环境,否则可能造成任务运行失败(若希望避免这种情况,请将开发环境保存成镜像,并使用保存的镜像进行训练)。

- 启动命令:

- 启动入口:镜像内的启动入口。若启动脚本为 py 文件,启动入口可以写为 python;若启动脚本为 sh 文件,启动入口可以写为 bash。

- 启动脚本:从发布内容 code 文件夹中选择启动脚本文件,仅支持 .py 或 .sh 格式。

- 接收平台参数:

- 数据集路径:模型训练数据集的挂载路径

- 增量训练权重路径:增量训练权重文件的挂载路径

- 任务输出路径:模型训练任务的输出路径。平台会分配唯一的持久化输出路径,请在代码中将需要保存的数据存储到此路径。

- 超参:模型训练的超参,以命令行参数的形式传递给启动脚本。

- 启动命令预览:可以预览完整的启动命令。

- 资源类型:模型训练时使用的资源类型。会自动填写开发环境使用的资源。

- CPU、GPU、NPU:模型训练推荐使用的资源规格。会自动填写开发环境使用的资源。

- 训练可视化:选择支持的可视化类型,请在代码中将可视化输出存储到接收平台参数的“任务输出路径”中,平台会自动读取。

- 分布式训练:若代码支持分布式训练,则可选择支持。

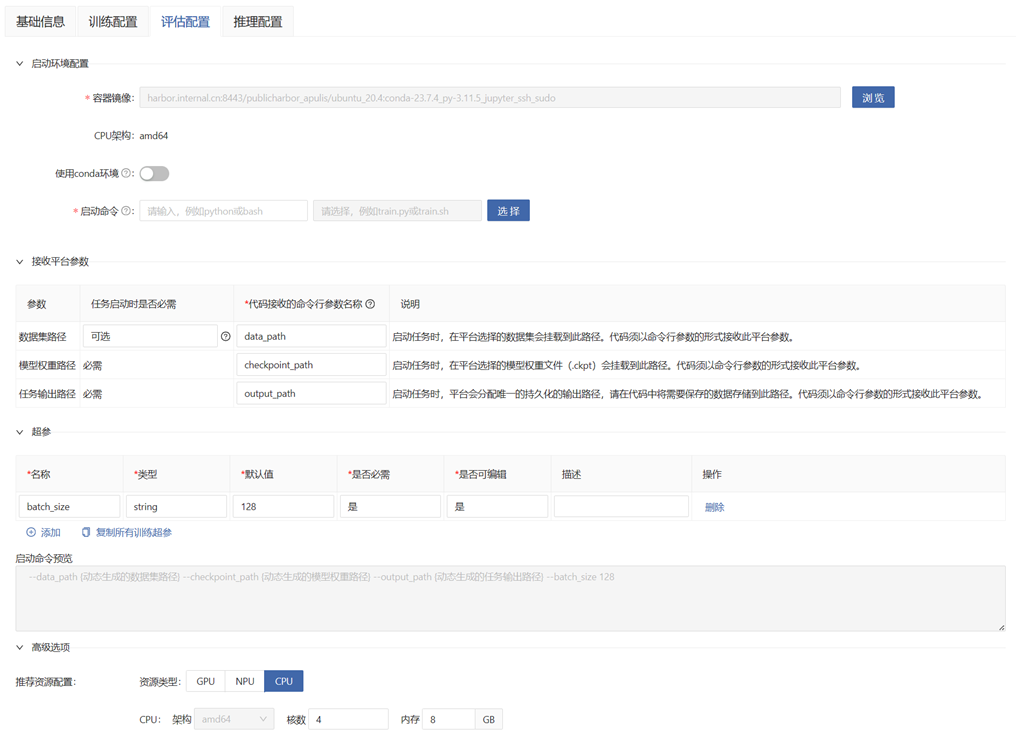

评估配置

若发布后需要进行模型评估,则需配置。也可发布后在模型库配置。使用此模型进行模型评估时,会按照下列配置信息启动任务:

- 容器镜像、CPU 架构、使用 conda 环境、启动命令、超参、启动命令预览、资源类型:同训练配置。

- 接收平台参数:

- 数据集路径:模型评估数据集的挂载路径

- 模型权重路径:模型训练生成的权重文件的挂载路径

- 任务输出路径:模型评估任务的输出路径。平台会分配唯一的持久化输出路径,请在代码中将需要保存的数据存储到此路径。

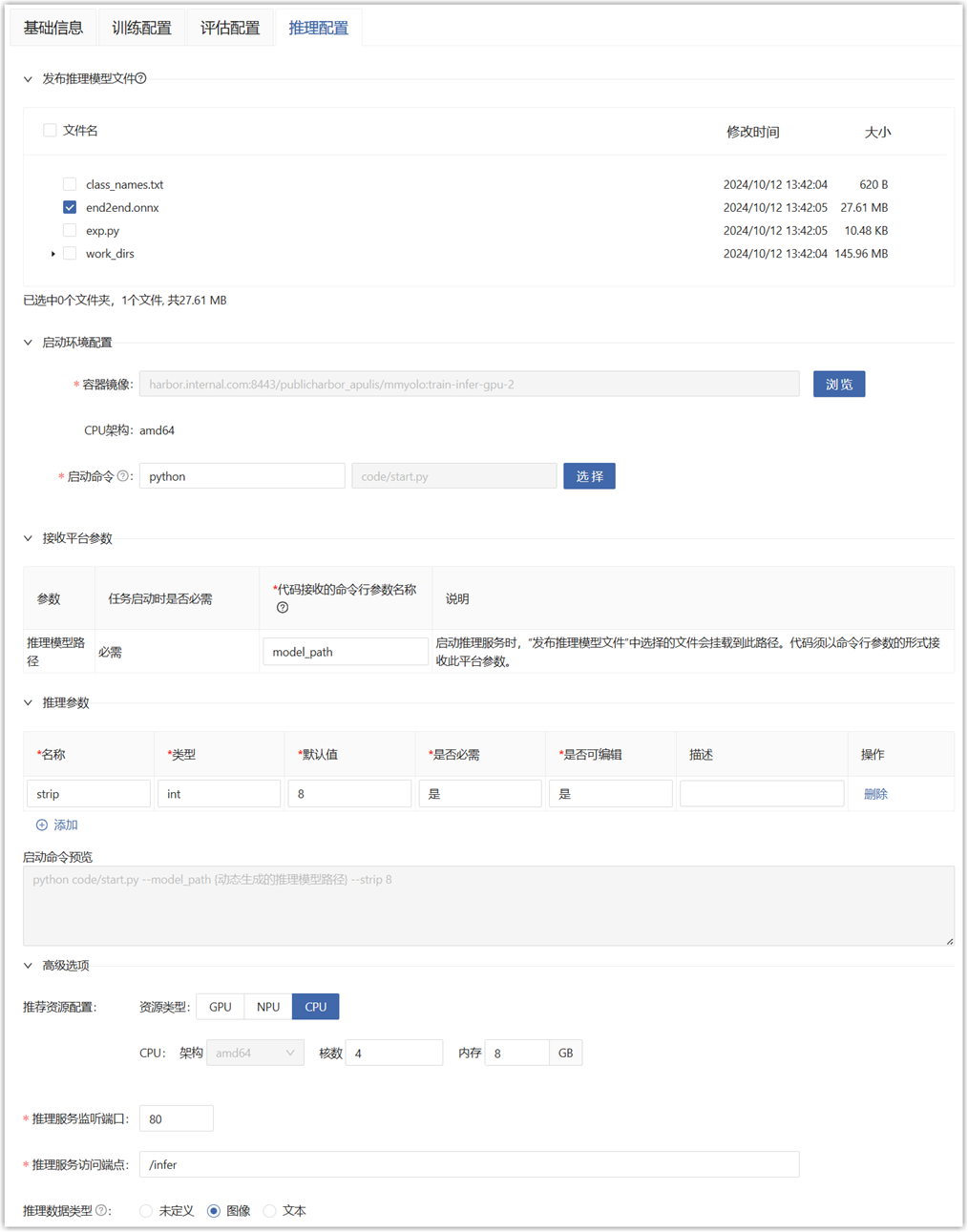

推理配置

若发布后需要进行模型推理,则需配置。也可发布后在模型库配置。使用此模型进行模型推理时,会按照下列配置信息启动任务:

- 容器镜像、CPU 架构、使用 conda 环境、启动命令、超参、启动命令预览、资源类型:同训练配置。

- 发布推理模型文件:

- 选择开发环境 outputs 目录中用于推理的模型文件,如 .ckpt、.pb、.pt、.pth、.onnx、.air、.om 等,发布时会拷贝到模型包的模型目录中,便于在平台管理推理模型。非必选。

- 推理的算法代码文件请在“基础信息”标签页中选择,请勿在此处选择。

- 启动推理服务时,模型目录会通过接收平台参数的形式传递给启动脚本。

- 接收平台参数:

- 模型权重路径:“发布推理模型文件”中选择的文件的挂载路径

- 推理服务监听端口:推理服务框架监听 HTTP 推理请求的端口

- 推理服务访问端点:推理服务框架处理 HTTP 推理请求的访问端点

- 推理数据类型:选择输入到推理模型的数据类型。平台使用不同的方式来可视化推理原始数据及推理结果:

- 未定义:不支持推理结果回传

- 图像:显示图像及图形化的推理结果

- 文本:显示文本及 json