12.10 Mindformers入门介绍

MindSpore Transformers套件的目标是构建一个大模型训练、微调、评估、推理、部署的全流程开发套件: 提供业内主流的Transformer类预训练模型和SOTA下游任务应用,涵盖丰富的并行特性。期望帮助用户轻松的实现大模型训练和创新研发。 MindSpore Transformers套件基于MindSpore内置的并行技术和组件化设计,具备如下特点:

一行代码实现从单卡到大规模集群训练的无缝切换;

提供灵活易用的个性化并行配置;

能够自动进行拓扑感知,高效地融合数据并行和模型并行策略;

一键启动任意任务的单卡/多卡训练、微调、评估、推理流程;

支持用户进行组件化配置任意模块,如优化器、学习策略、网络组装等;

提供Trainer、pipeline、AutoClass等高阶易用性接口;

提供预置SOTA权重自动下载及加载功能;

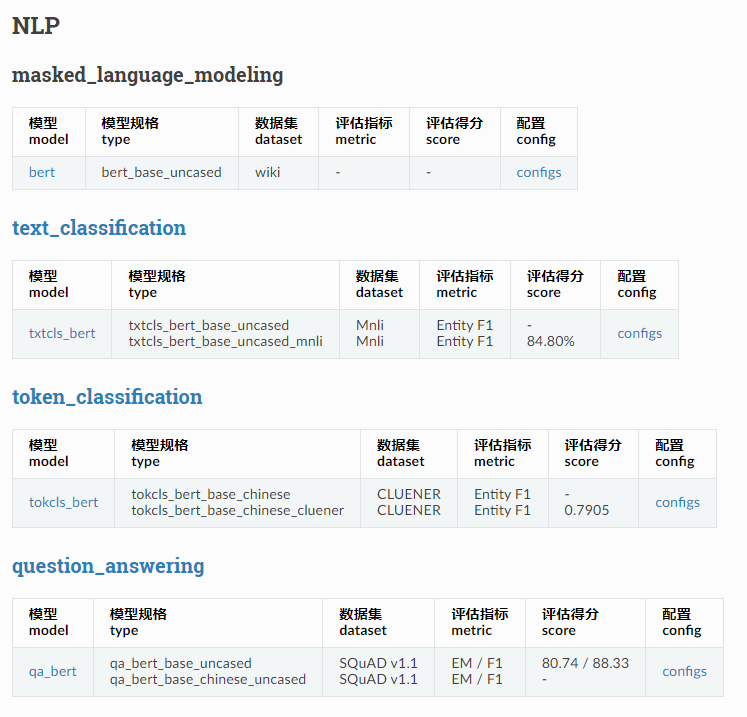

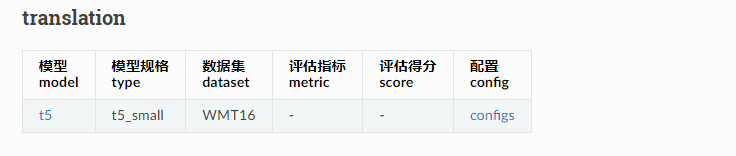

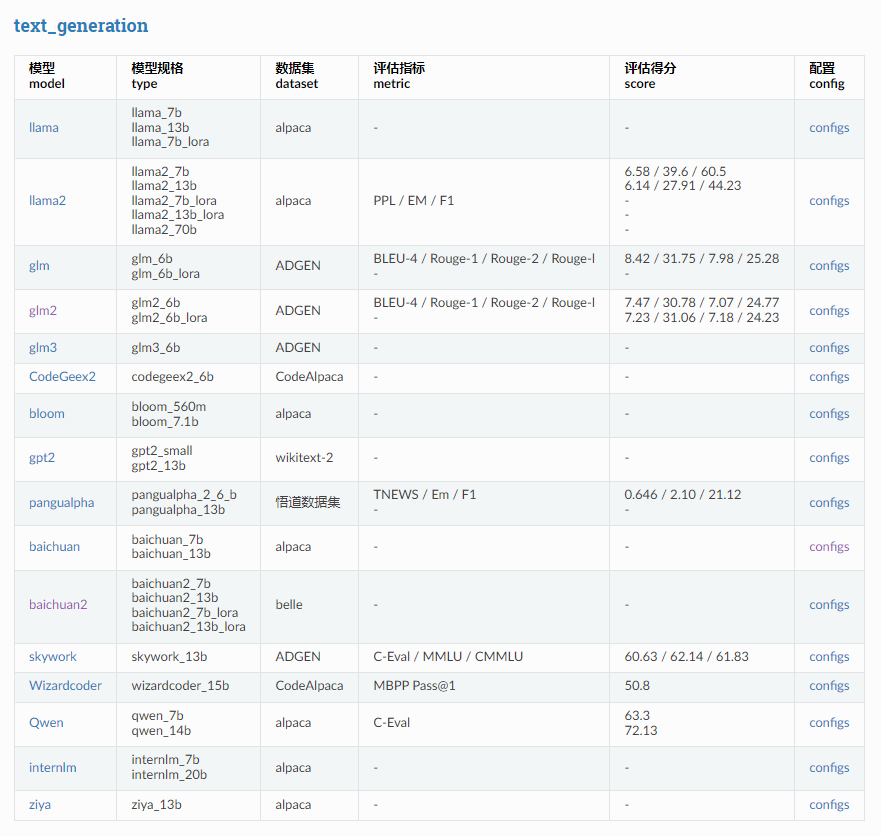

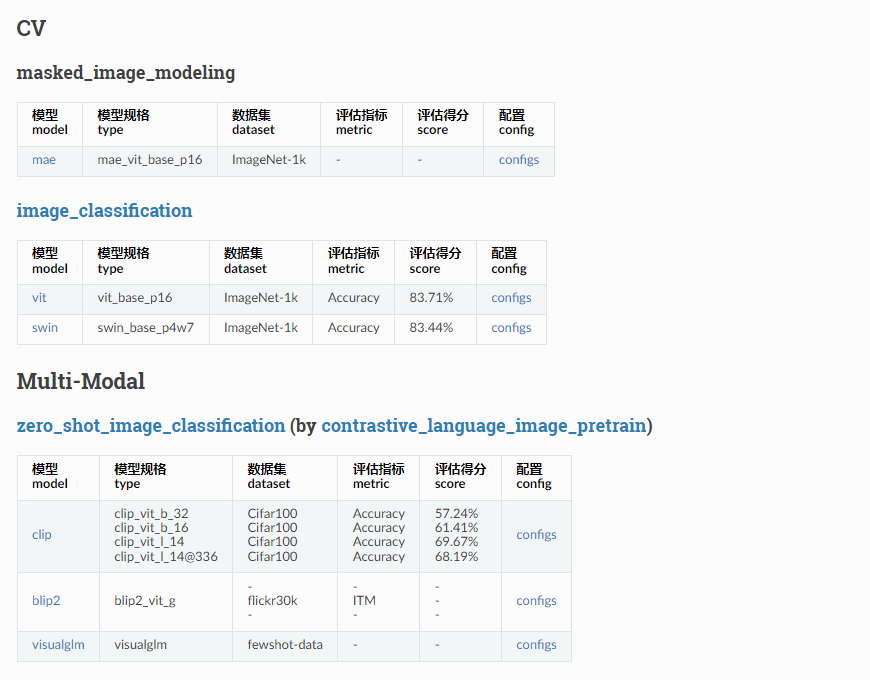

支持人工智能计算中心无缝迁移部署; 目前支持的模型列表如下:

模型 model name LLama2 llama2_7b, llama2_13b, llama2_7b_lora, llama2_13b_lora, llama2_70b GLM2 glm2_6b, glm2_6b_lora CodeGeex2 codegeex2_6b LLama llama_7b, llama_13b, llama_7b_lora GLM glm_6b, glm_6b_lora Bloom bloom_560m, bloom_7.1b GPT2 gpt2, gpt2_13b PanGuAlpha pangualpha_2_6_b, pangualpha_13b BLIP2 blip2_stage1_vit_g CLIP clip_vit_b_32,clip_vit_b_16,clip_vit_l_14,clip_vit_l_14@336 T5 t5_small sam sam_vit_b, sam_vit_l, sam_vit_h MAE mae_vit_base_p16 VIT vit_base_p16 Swin swin_base_p4w7 skywork skywork_13b Baichuan2 baichuan2_7b,baichuan2_13b,baichuan2_7b_lora, baichuan2_13b_lora Baichuan baichuan_7b, baichuan_13b Qwen qwen_7b, qwen_14b, qwen_7b_lora, qwen_14b_lora Wizardcoder wizardcoder_15b Internlm internlm_7b,internlm_20b,internlm_7b_lora ziya ziya_13b VisualGLM visualglm

模型支持列表